Google 自家的語言模型 Gemini 在推出約 2 個月後就馬上就迎來了第一次升級;日前 Google 正式發佈最新一代語言模型 Gemini 1.5,對比 Gemini 1.0 不僅性能與功能皆有顯著提升,甚至可支援處理多達 100 萬個 token,也就代表能應付更長、更複雜的任務。

Gemini 1.5 性能更強,與 Ultra 1.0 版本不相上下

Google 說明 Gemini 1.5 採用「專家混合( Mixture of Experts / MoE)」架構,MoE 會將語言模型劃分為多個專家模塊,每一個專家模塊都專注於處理特定任務;當用戶給出指令時,模型就會根據指令內容啟用相關的專家模塊,不會一次就使用整個模型,從而提高處理性能與效率,也可有效提升模型的擴展性。

目前 Google 釋出的第一個 Gemini 1.5 通用版本是定位中階的 Gemini 1.5 Pro;而 Gemini 1.5 Pro 表現非常亮眼,不僅在 87% 的基準測試中勝過 Gemini 1.0 Pro,整體性能甚至已經跟之前最高階的 Ultra 1.0 不相上下。

Gemini 1.5 可處理多達百萬個 token

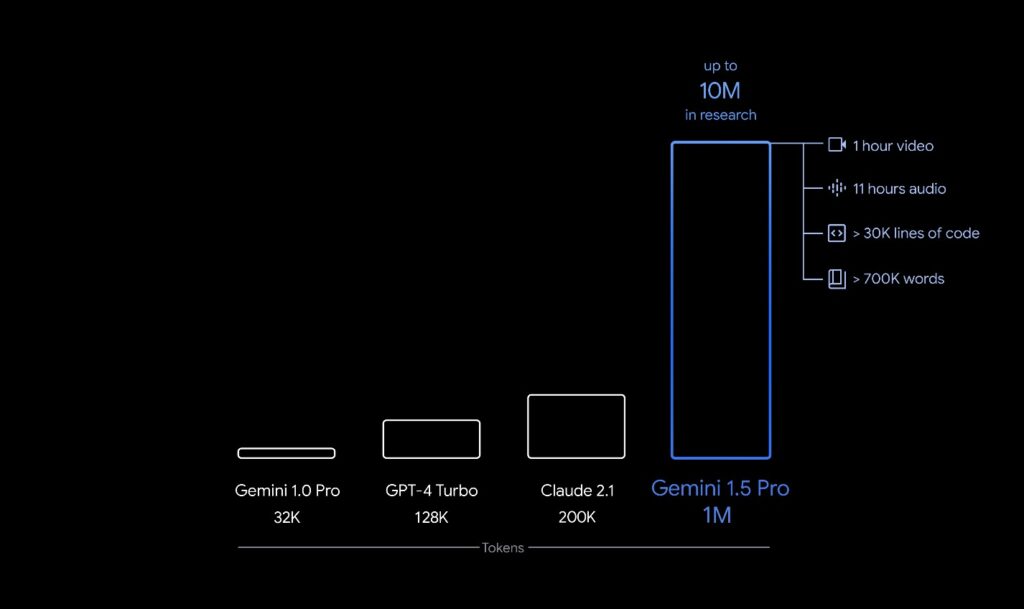

Gemini 1.5 還可處理多達 100 萬個 token,不只比前代提升約 30 倍左右,也遠超其他大型語言模型(Gemini 1.0 為 32,000 個、GPT-4 Turbo 為 128,000 個、Claude 2.1 為 200,000 個)。

這相當於可一次性處理 1 小時的影片、11 小時的音訊、超過 3 萬行程式碼或超過 70 萬字的程式庫;更驚人的是 Google 內部也已經成功測試了使用 1,000 萬個 token 的 Gemini 1.5 模型。

關於處裡能力的部分,Google 有展示出 3 種情境:

首先是大量複雜資訊處理,例如 Gemini 1.5 可理解、推理、識別多達 402 頁的阿波羅 11 號登月任務文字紀錄 PDF 檔;此任務需要 326,914 個 token。

或是給 Gemini 1.5 看一部時長 44 分鐘、由巴斯特·基頓出演的默劇,它可以準確分析劇情中各個時間點的人、事、物,甚至可以對劇情中容易被錯過的小細節進行推理;此任務需要 696,417 個 token。

最後讓 Gemini 1.5 處理超過 100,000 行程式碼,它能分析內容、提出修改建議、並解釋不同段落程式碼的運作原理;此任務需要 816,767 個 token。

Gemini 1.5 未來將取代 Gemini 1.0,也就是說大家都用得到;但標準版 Gemini 1.5 Pro 僅提供支援 12.8 萬個 token、付費版本才可使用 100 萬個 token,這就看個人需求。

不過 Google 也有提到未來會計畫把標準版 Gemini 1.5 Pro 擴展至 100 萬個 token,就看之後 Google 會提供怎樣的方案給用戶選擇。

更多 AI 相關資訊》

- OpenAI 推出全新影片生成模型「Sora」,可依文字敘述生成 60 秒超逼真影片

- Google Bard 正式改名 Gemini:並推出 Gemini Advanced 方案,連手機也能用

- Google Bard 開放免費使用 AI 文字生成圖片功能

- 目標強化 AI 搜尋體驗!Google 宣布推出「畫圈搜尋」與「AI 多重搜尋」功能