圖、文/愛范兒

剝離技術和參數的外衣,探求設計與人文的本源。

沒有太多硬體基因的Google,對於智慧型手機產品一直有另一番理解,尤其是在拍照方面。

2016 年10 月5 日,Google CEO Sundar Pichai 提出了由「移動優先」轉為「AI 優先」的口號,同日亮相的第一代Pixel 手機就是這個理念的體現。

表面上看,Pixel 使用的鏡頭和更早推出的Nexus 6P 並沒有太大變化,大家都是一樣的1230 萬像素和1.55 μm 的單像素尺寸,區別僅僅是加入了相位對焦功能。

但兩者卻在DxOMark上獲得了完全不同的評價—— Nexus 6P只有不起眼的73分,但Pixel卻憑藉89分拿下了當時的榜首。

![]()

之後的第二代Pixel推出時,Google也開始把關鍵賣點放在了拍照上,這款手機的評分漲到了98分,一舉超過同期的三星Galaxy Note 8和蘋果iPhone 8 Plus再度登頂,DxOMark當時給出的評語是「創下智慧型手機相機質量的新記錄」。

連續兩次拿下榜單首位,加上媒體和用戶的好評如潮,開始讓Google 親兒子手機散發出一種神秘的吸引力。

雖然DxOMark 的得分僅僅只是一個參考,但其中最讓人不解的是,兩代Pixel 手機都僅憑單鏡頭就獲得了這一成績,而其它手機卻都是後置雙鏡頭,難道Google 的AI 算法真的已經強大到能無視物理硬體了嗎?

![]()

▲圖片來自:Gizmodo

哪怕是在今天,新發表的Pixel 3 手機也依舊沒有採用時下主流的雙鏡頭乃至是三鏡頭組合,這種「靠一個鏡頭獨步天下」的功力,除了Google 你也很難再找到第二家了。

但現在來看,它確實有這份「任性」的資格和底氣。

Pixel 3 的鏡頭有多聰明?

在大眾用戶的認知中,攝影的過程無非就是三個步驟:1)看到自己想拍的東西;2)打開相機按下快門,記錄這個瞬間;3)獲得一張靜止不動的照片。

專業攝影師就不一樣了。他們得根據現場的光照情況對應調整快門和光圈大小,選擇合適焦段的鏡頭,拍攝時會考究構圖和按快門的時機,拍完還要拿去PS 或LR 里後期一下,最終才得出了我們眼中的各種「大片」。

![]()

▲圖片來自:Businessinsider

但智慧型手機的普及改變了這一切,不管是Pixel 還是iPhone 或其它手機,手機廠商都在淡化原本只有攝影師才懂的ISO、曝光時間等數值,這些交給處理器和算法完成就好了,用戶只要懂得按下快門,也能拍出一張媲美卡片機的照片。

Google 顯然也懂得這個「拍照傻瓜化」的道理,只是比起尋求專用硬體來點亮更多的技能樹,它更喜歡利用AI 和各種堆棧算法來解決問題。

這種思路很有趣,說白了,它希望讓機器自己去學習如何才能拍得更好。

![]()

在去年的Pixel 2系列中,Google專門加入了一顆名為「Pixel Visual Core」的定製圖像處理單元,這是Google與英特爾合作開發的8核心協處理器,目的是用來加速各種與AI拍照相關的任務,比如Pixel系列一貫主打的HDR+。

而在Pixel 3 上,這顆Visual Core 核心也獲得了更新,它的處理速度比去年快了40%,意味著它能對更快地處理各種繁雜的照片源數據,在機器學習的幫助下還讓Pixel 3 解決了一些日常拍照的痛點。

![]()

首先是名為「Top Shot」的照片精選特性,它能夠在你按下快門時自動記錄前後數秒的影像,有點類似iPhone 中的Live Photos,但此時AI 還會自動將「最佳時刻」打上標籤供你挑選,所以就算是你不小心拍到別人閉眼的窘態,也可以選擇其它畫面作為最終照片。

▲「Night Sight」不僅適用於後置,也適用於前置。圖片為Google 官方樣張

至於在伸手看不清五指的場景下,Google 給出的方案是「Night Sight」夜景模式,這個功能的核心還是藉助HDR+ 的連續採樣和多影像合成,目的是盡可能地提高照片的亮度,徹底解決「暗光拍不到」的問題。

![]()

為了強調這個模式的出眾效果,Google 在發表會上還對隔壁iPhone XS 進行了一番比較,也不知道蘋果此時的心情是怎麼樣的。

還有一個是「Super Res Zoom」,主要是取景是變焦後圖片放大的情況,其實是將一些傳統單反中的「像素偏移模式」用在了變焦功能上。

▲ engadget日本使用Pixel 3拍攝的樣張,如果放大圖中框選的部分…圖片來自:engadget

▲這是Pixel 3放大後的樣張。圖片來自:engadget

具體來說,Google 抓住了我們取景時都會輕微抖動的小細節,它會在這個過程自動根據手部運動移動感光元件,然後並連續抓拍數張照片,再藉助算法進行合成。

在這個方式下,每個像素都可以獲得足夠的RGB 資訊,最終便能實現一張擁有超高解析力的照片。

按照Android Central的說法,哪怕是放大8倍,Pixel 3的變焦照片仍然能保持和Pixel 2上2倍變焦的清晰度。這意味著就算沒有獨立的長焦鏡頭,Pixel 3仍然可以拍出不亞於光學變焦效果的照片。

Google 延展的不止是拍照的廣度,還有拍照的深度

我們已經看過所有能選擇的鏡頭組合,單純加一顆鏡頭對我們而言並沒有好處。

在Pixel 3發表會後,Google的產品副總裁Brian Rakowski這樣說道。在他看來,Pixel手機已經能通過傳感器獲得足夠多的訊息,之後再通過機器學習等方式,同樣能產生用戶所需要的照片。

本質上看,Google是在嘗試用「計算攝影(Computational Photography)」的概念,為傳統攝影引入AI機器學習等高級算法,等同於是對解析度、光照、對焦點和景深等這類圖像資訊進行一次重新梳理,以此突破單鏡頭的物理邊界。

打個比方,以Pixel 2中的HDR+為例,表面上看你用手機拍照只是打開取景器再咔嚓一聲,可暗地裡鏡頭在你打開取景器後就開始採集工作了,這些數據會即時保留在手機中,並最終被合成算法所調用。

除此之外,Google 還將圖片分割成一個個獨立的方塊,保留高動態範圍和細節的同時,也會盡可能地去除模糊、鬼影和噪點。

![]()

還有像前文提到的「Top Shot」這種「先拍後選」的模式,其實也受到了計算攝影思維的影響,它們都是在用戶無法感知到的底層去實現。

DPReview近期採訪了Pixel的相機產品經理Isaac Reynolds以及計算攝影主管Marc Levoy,他們表示,為了保證零延遲快門的體驗,當初Pixel 2的安全快門值設為了1/15秒,這樣哪怕是在最糟糕的暗光環境,HDR+也可以保證在0.6秒內對最高9張圖像進行合成;若是光線充足狀態下則可以縮短到150毫秒。

很顯然,用戶是不會感知到這些後處理流程的,呈現在我們眼前的只是最終的成品照。

而在Pixel 3 上,用於「Super Res Zoom」變焦模式的合成圖像會高達15 張之多,而「Night Sight」夜景模式更是犧牲了零延遲快門。

它和一些手機的超級夜景一樣,需要你在按下快門的同時保持機身穩定,此時相機會捕捉最高15 張照片並進行合成,每張照片的快門速度最低為1/3 秒,由此來獲得接近5 秒曝光效果的照片,其中因手抖而糊掉的照片也會被自動剔除。

不僅如此,考慮到黑暗環境下的糟糕光源,「Night Sight」拍攝出來的照片也會藉助機器學習來實現自動白平衡。

![]()

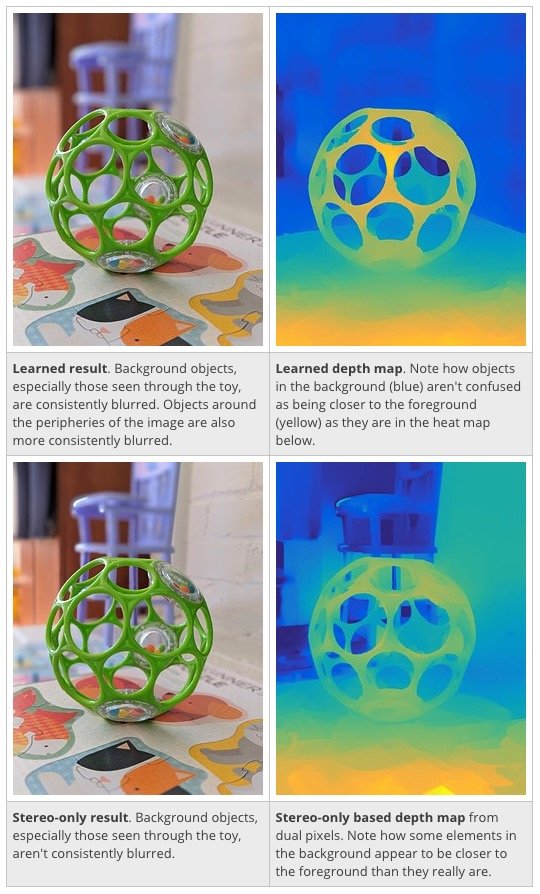

另一個不得不說的是自Google Pixel 2 時代就備受好評的人像模式,雖然這款手機並沒有配備雙鏡頭,但依舊可以拍出不輸於同期雙鏡頭旗艦的虛化照片。

實際上,它藉助的是鏡頭傳感器的PDAF 雙像素特性,來捕獲左右兩種視覺圖像,從而得到簡單的深度資訊,然後再依靠圖像分割技術,對圖像輪廓進行精准定位。

在這個過程中,Google 花了不少心思訓練了一個神經網路模型,它會根據深度資訊分辨出照片中哪些部分屬於人物,哪些部分是屬於背景的,畢竟只有分清前景和後景,算法才能對正確的區域進行虛化處理,最終才能合成一張淺景深的照片。

▲上圖為機器學習參與後的深度資訊圖,下圖則是單純基於雙像素和立體算法的深度資訊圖,背景椅子的部分可以看到明顯的差異。圖片來自:DPReview

在今年的Pixel 3 上,Google 對深度映射算法又做了新的調整,通過機器學習來獲取更精準的深度圖。

從上面的對比圖中也能看到,如果只是單純基於雙像素和立體算法,碰到像掏空的玩具球、玻璃杯或是有網格欄杆這類前後景模糊的場景時,深度資訊很可能會識別出錯。

但在機器學習參與後,整個虛化效果和範圍就跟以前不一樣了。

有了AI 拍照,能讓Pixel 手機變得和iPhone 一樣流行嗎?

Google 是靠搜尋和工具業務起家的,本質上不是一家硬體公司,即使是Pixel 手機,它的整個重心都是圍繞服務和AI 展開的。

所以在歷屆Pixel 發表會上,最出風頭的仍然是Google 的軟體服務。演講人不會對配置做太多的介紹,更多會去強調那些「只有Pixel 手機才能用上的功能和服務」,這其中就有各種AI 拍照的身影。

▲圖片來自:Post and Courier

但面對蘋果、亞馬遜等巨頭公司的步步緊逼,Google 又不得不做硬體,就像Google 的硬體負責人Rick Osterloh 所說的那樣,他要找到更多的方法讓Google 智慧型助手出現在人們面前。所以你不僅能看到Pixel 手機,還有各種音箱、耳機與平板電腦。

這並不是一個主流的玩法,在很多人看來,智慧型手機是一門硬體生意,推動消費者每年換手機的動力來自更好看的外觀、更強的處理器和更多的鏡頭,各種手機產品的橫向比較也只是硬體參數的對比,而無法量化的軟體只能一筆帶過。

畢竟,除了iPhone,其它主流手機都是用Android 作為底層,跑同樣的apk 應用,也唯獨只有硬體能做出比較大的差異。

可Pixel 手機依舊和其它Android 不一樣,這是Google 親自參與的,只有它能夠將Android 系統改造成自己想要的東西,不然你也不會看到那麼多基於底層的拍照算法。

在AI 加持下,沒人能猜到Pixel 手機還能帶來多少我們所不知道的玩法。

▲ 圖片來自:Nagisa Ichikawa

但AI 並非無所不能,Pixel 3 上依舊有隻能靠硬體來實現的特性。比如說新加入的800 萬前置廣角鏡頭,就是專門用來拍多人集體照和大場景自拍的,這兩種場景都沒辦法靠傳統的自拍鏡頭實現。

還有那顆Visual Core 核心,如果沒有它的協助,Pixel 3 的AI 拍照也無從談起。

歸根結底,手機中的AI 仍然要依靠足夠的計算力來驅動,沒有優秀的硬體做基礎,軟體體驗顯然得打個對折。

但Google 顯然在為手機攝影帶來另一種發展方向,這也給那些原本就有強大物理硬體加持的同僚們更多啟示。當然,也無疑讓消費者們對手機拍照有了更大的期待。

題圖來源:Nagisa Ichikawa