昨天果仁報導過:用 iPhone 傳色情照片將被自動打馬賽克,還會檢查 iCloud 內的兒童色情照片。當中有一項會模糊訊息中的色情照片功能,目前經過外媒確認,這項功能只會針對兒童用戶啟用,須透過父母設定,成人用戶不會受到影響。

訊息 App 阻擋功能,只會針對兒童用戶啟用

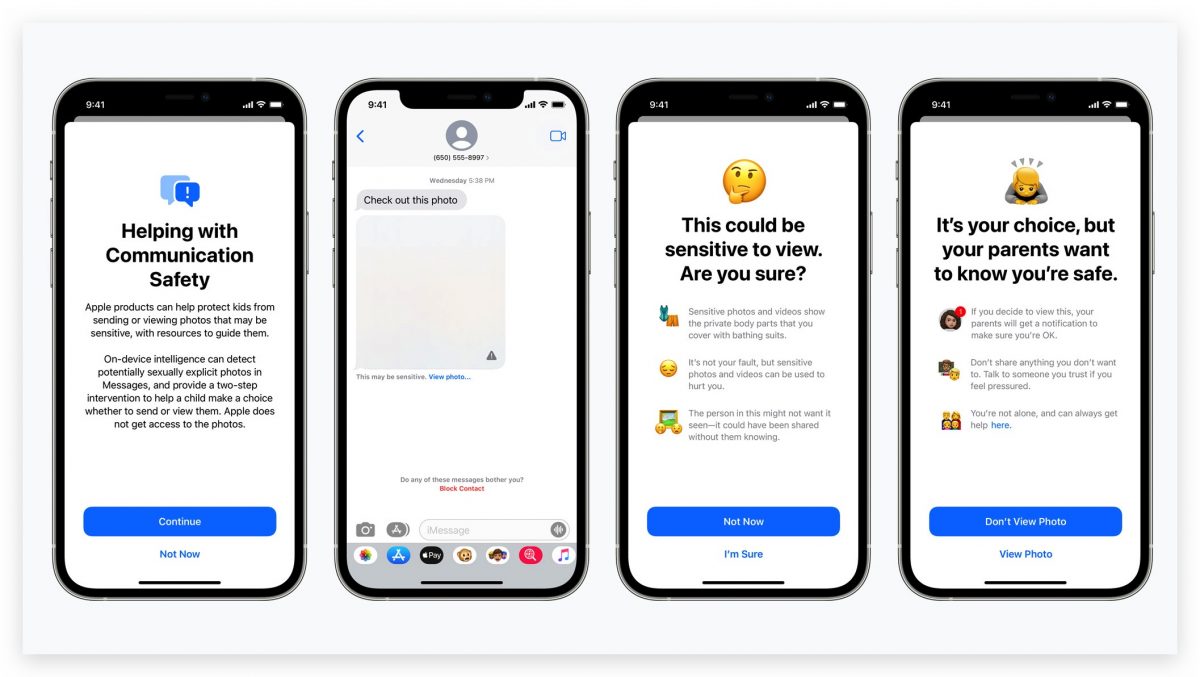

這項名為「通訊安全」的新功能,會利用機器學習的方式,分析訊息中的任何敏感內容,蘋果不會從中獲取任何資訊。在接收或傳送含有色情內容的圖片時,會向孩童與其父母發出警告訊息。

收到敏感內容的照片時,照片會自動模糊,兒童不會看到相關的敏感內容。同時為了確保孩童安全,在收到或是發送內含敏感內容的訊息時,孩童與家長都會收到警告訊息,即時阻止敏感訊息傳播。

外媒表示:蘋果已確認,通訊安全功能,必須由家長透過「家人共享」啟用。家長可以幫孩子的 Apple ID 帳號打開通訊安全功能。成人帳號無法啟用通訊安全功能,通信安全只適用於 18 歲以下的用戶。

蘋果保證通訊安全功能不會有隱私問題

至於大家關心的隱私問題,蘋果則保證:通訊安全是利用機器學習的方式,分析訊息中的任何敏感內容,由於他會在裝置上運作,而且訊息內容仍然會使用端對端加密,蘋果不會從中獲取任何資訊。

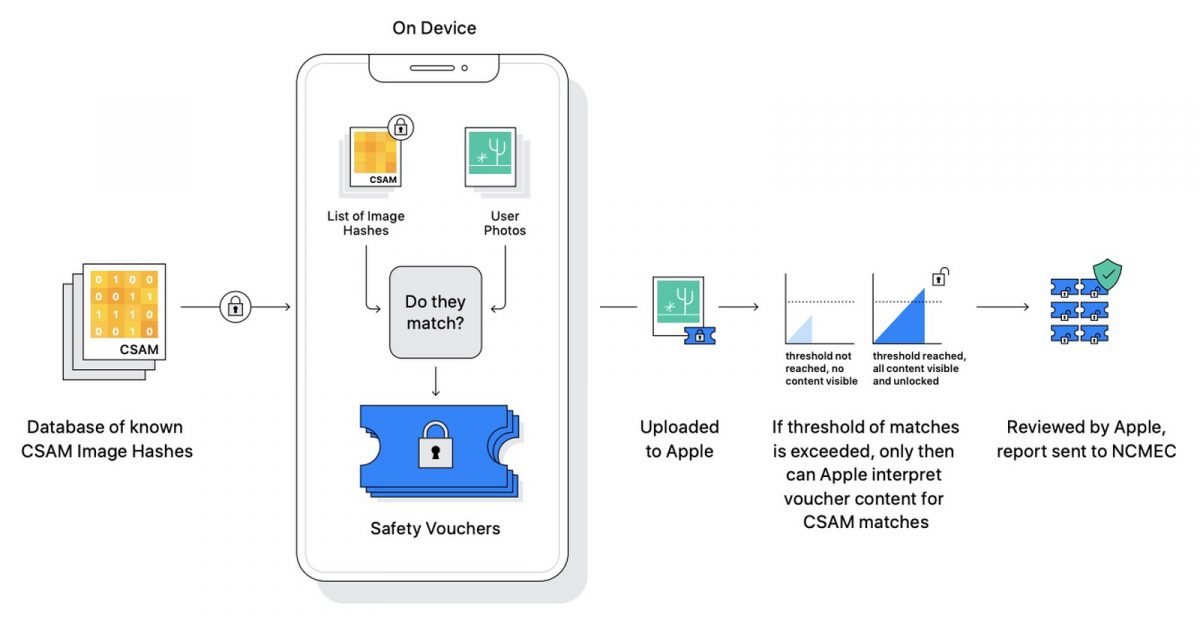

同時,蘋果也再次強調,兒童色情照片的檢查功能,不會掃描用戶裝置上的圖片庫,而是利用數字密碼的方式,與 NCMEC 還有其他兒童安全組織提供的 CSAM 圖像資料庫進行比對,因此蘋果不會看到實際上的照片,只有當上傳的違規照片到達一定的數量,蘋果才會查閱違規內容,並使用人工的方式逐一檢查。

蘋果表示這一套安全功能,已經研發多年,並不是為了監控用戶而設計,而是為了阻止兒童性虐待素材 CSAM(Child Sexual Abuse Material)傳播。目前這套安全系統只有在美國地區使用,未來會擴及到全球各地。且只有在 iCloud 照片功能打開時才會啟用。

延伸閱讀》

- 「可能接觸過肺炎患者!」蘋果與 Google 公布手機的警告方式

- 家長如何限制兒童看 Netflix 的影片?善用家長控制功能就行

- 不用再等 3 天!AirTag 的跟蹤警告提示將縮短為 8 到 24 小時