近幾個月以來,無論是企業或是個人,很多人都會利用 AI 聊天機器人來協助自己完成工作,就算是國際企業也不例外,IBM 執行長最近就透露因為 AI 的關係,IBM 已經暫停招募將近 7000 多的應該招募的職缺。

但是根據彭博報導,三星電子近期反而是決定禁止員工使用 ChatGPT 這類的 AI 生成式工具,當然主要的原因也與多次的內部會議資訊外洩有關。

ChatGPT 資安疑慮引發 Samsung

在過去的一個月裡,三星發生了 3 起使用 ChatGPT 導致資料洩漏的事件。

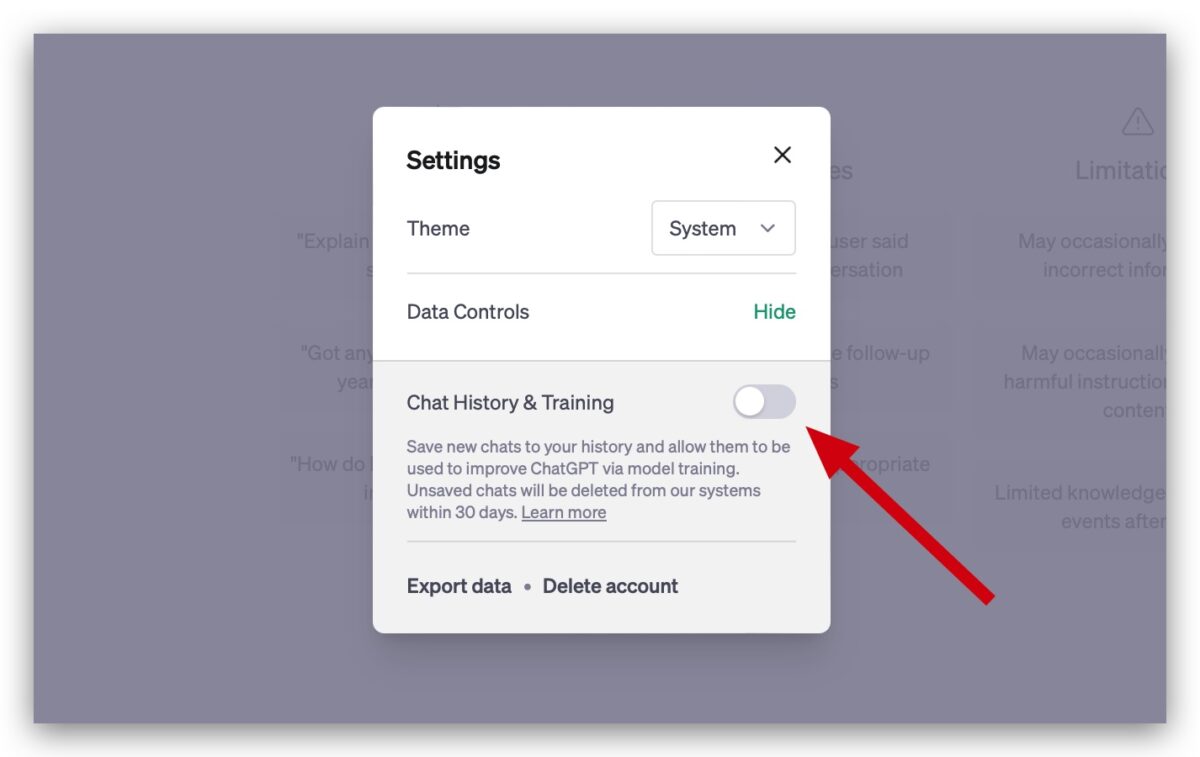

原本在前陣子 ChatGPT 推出新功能讓使用者可以自由選擇對話紀錄是否要被留存,因此有傳出三星僅是要求員工在使用 ChatGPT 時,要記得把不儲存對話紀錄的功能打開的消息,也就是三星的員工還是可以繼續使用 ChatGPT,只是必須小心對話紀錄是否被保存。

但因為即便開啟了不儲存對話紀錄的功能,ChatGPT 還是會暫時保存對話資料一個月,所以三星還是擔心數據資料傳輸至 AI 平台後,可能被儲存在外部伺服器,導致機密資料遭到外洩。

此外,三星上個月進行的一項內部調查顯示,有 65% 的員工也認為這類 AI 工具存在資訊安全風險。

三星開發自家 AI 並頒布新規定,違者開除

為了保護公司數據但又避免完全捨棄 AI 協助工作流程導致失去的 AI 的優勢,三星正積極開發自家的 AI 工具,同時也制定了一系列新規定。

新的規定禁止三星內部員工在公司電腦、平板、手機以及內部網路使用生成式 AI 工具,但並不影響三星對外販售的產品,畢竟不可能說我買了三星的手機或平板結果不能開啟 ChatGPT 吧。

上面是針對使用公司內部的設備,那如果是使用自己的設備呢?三星要求在個人裝置上使用 ChatGPT 的員工不得輸入與公司相關的資訊,以及可能洩漏智慧財產的私人資料。

違反上述規定的員工可能面臨被開除的處分。

不只三星,多家企業也是對 AI 的資安保護也疑慮

事實上,三星並非唯一擔心 AI 技術帶來資安風險的大型企業。今年 2 月,ChatGPT 在科技業引起廣泛關注後,包括摩根大通、美國銀行和花旗銀行在內的華爾街銀行紛紛開始禁止或限制員工使用該 AI 工具。

這些企業除了擔憂資訊安全之外,也對侵犯隱私表示擔心。

延伸閱讀》

- ChatGPT 爆個資外洩風險,網友在聊天紀錄中看到別人的內容

- 微軟推出 Security Copilot:用對話的方式就能幫你分析資安漏洞

- 假 ChatGPT 擴充功能出沒請小心,內藏惡意程式還會竊取 FB 帳號

如果想知道更多關於 Apple 的消息、教學、小技巧或是科技新知,一定要點擊以下任一 LOGO,追蹤我們的 Facebook 粉絲團、訂閱 IG、YouTube 以及 Telegram。