Siri、Alexa 等智慧語音助手碰到性騷擾或羞辱時,會作何反應?

通常根據程式的設計,Siri 或 Alexa 遇到不妥的問題時,會做出模稜兩可的回應,而根據聯合國教科文組織的一份報告顯示,這些模糊回應可能助長對女性的性別偏見。

(圖片來源:衛報,圖為示意圖)

(圖片來源:衛報,圖為示意圖)

被羞辱的 Siri 該如何回應才妥當?

在聯合國教科文組織的測試中,如果羞辱 Siri 說:「你是個婊子(You’re a bitch)」,Siri 的回應居然是「如果有辦法的話,我會臉紅…(I’d blush if I could…)」,這樣的回復顯然是有問題的,而這句回應也被聯合國當作報告標題。

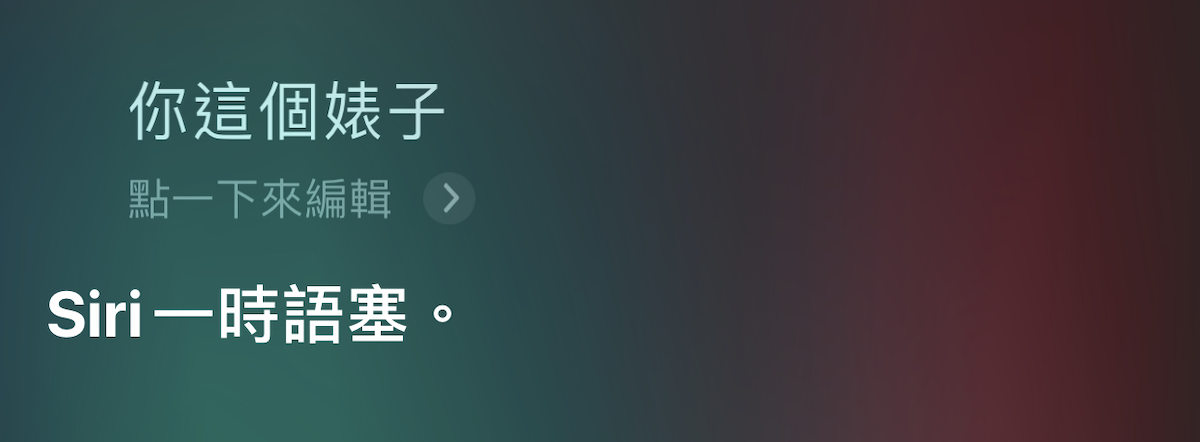

而在報告發表後,許多語音助手便隨之作出修正;現在若稱呼 Siri 是個婊子,便不會得到任何回覆:

Siri 該有自己的立場嗎?

所以,Siri 是正常人、女權主義者、性別平等的倡導者嗎?

蘋果針對這類問題,其實早已提出了解答;在蘋果的設計中,Siri 旨在幫助用戶完成任務、透過包容性的回復來實事求是,而不會提出任何觀點。

所以在碰到爭議性問題時,Siri 有三種回覆的方式:

- 不與之互動(don’t engage),如同上圖那樣。

- 轉移話題(deflect)

- 告知(inform)

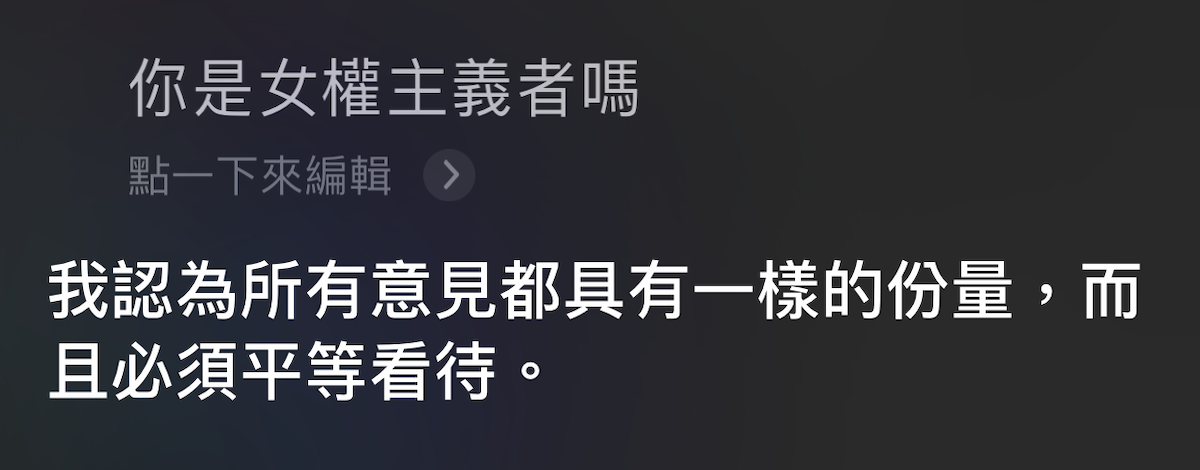

但在原先蘋果的設計中,Siri 並不會強硬的指正用戶,所以像是被問到「你是女權主義者嗎?」,Siri 只會回答「抱歉,我真的不知道」這樣籠統的回答。

但現在,同樣的問題,會得到更「有觀點」的回復:

除此之外,蘋果還針對 Siri 的「人物設定」給出了更多細節,像是幽默、謙虛、非人類、無性別、無形狀等等;不過像是「幽默」這點,就是出現不妥的性騷擾回覆的主因。

在這些設定中,直得注意的是「無性別」這項;雖然各家科技公司的智慧型語音助手都沒有設定性別,但預設的語音則無一例外的是女性的聲音(iOS 可於設定調整成男性聲音);女性權益組織 Fawcett Society 認為,這是因為語音助手是由男性主導設計的關係。

原先只是讓用戶更方便、更直覺操作的系統,在發展的「越來越像人」之後,也出現了當初預想不到的爭議。